Was studiert Informatik?

Das Computing Es ist eine moderne Wissenschaft, die die Methoden, Prozesse und Techniken untersucht, um Daten auf digitale Weise zu verarbeiten, zu übertragen oder zu speichern. Mit dem großen technologischen Fortschritt ab der zweiten Hälfte des 20. Jahrhunderts gewann diese Disziplin an Bedeutung für produktive Aktivitäten und erhöhte gleichzeitig ihre Spezifität..

Die Entwicklung von Computern, geschlossenen Kreisläufen, Robotern, Maschinen, Mobiltelefonen und das Aufkommen des Internets machen das Rechnen zu einer der beliebtesten Wissenschaften der letzten Jahrzehnte..

Die Etymologie des Wortcomputers hat mehrere mögliche Ursprünge. Es entstand hauptsächlich als Akronym für die Wörter Information und Automatique (automatische Information).

1957 war es Karl Steinbuch, der diesen Begriff in ein Dokument namens aufnahm Informatik: Automatische Informationsverarbeitung. 1962 benannte der französische Ingenieur Philippe Dreyfus seine Firma als Société d'Informatique Appliquée. Der Russe Alexander Iwanowitsch Michailow war jedoch der erste, der diesen Begriff als "Studium, Organisation und Verbreitung wissenschaftlicher Informationen" verwendete..

In ihrem weiten Anwendungsbereich widmet sich diese Wissenschaft der Untersuchung der automatischen Verarbeitung von Informationen unter Verwendung elektronischer Geräte und Computersysteme, die für verschiedene Zwecke verwendet werden können..

Was studiert Informatik? Anwendungen

Das Anwendungsgebiet der Informatik hat sein Spektrum mit der technologischen Entwicklung im letzten halben Jahrhundert erweitert, insbesondere aufgrund der Impulse von Computern und Internet..

Die Hauptaufgaben umfassen Design, Entwicklung, Planung geschlossener Kreisläufe, Dokumentvorbereitung, Überwachung und Prozesssteuerung..

Es ist auch verantwortlich für die Entwicklung von Industrierobotern sowie für Aufgaben im Zusammenhang mit dem weiten Bereich der Telekommunikation und die Erstellung von Spielen, Anwendungen und Tools für mobile Geräte..

Konformation des Rechnens

Informatik ist eine Wissenschaft, in der Wissen und Wissen aus verschiedenen Disziplinen zusammenwachsen, angefangen bei Mathematik und Physik bis hin zu Computer, Programmierung und Design..

Diese synergetische Vereinigung verschiedener Wissenszweige wird beim Rechnen durch die Begriffe Hardware, Software, Telekommunikation, Internet und Elektronik ergänzt..

Geschichte

Die Geschichte des Rechnens begann lange vor der Disziplin, die ihren Namen trägt. Es begleitete die Menschheit fast von Anfang an, ohne jedoch als Wissenschaft anerkannt zu werden.

Seit der Entstehung des chinesischen Abakus, der 3000 v. Chr. Aufgezeichnet wurde und als erstes Rechengerät der Menschheit gilt, können wir über Computer sprechen.

Diese Tabelle ist in Spalten unterteilt, die es durch die Bewegungen ihrer Einheiten ermöglichen, mathematische Operationen wie Addition und Subtraktion auszuführen. Es könnte den Ausgangspunkt dieser Wissenschaft geben.

Aber die Entwicklung des Rechnens hatte gerade erst mit dem Abakus begonnen. Im 17. Jahrhundert schuf Blaise Pascal, einer der bekanntesten französischen Wissenschaftler seiner Zeit, die Rechenmaschine und trieb einen weiteren Evolutionsschritt voran.

Dieses Gerät diente nur zur Addition und Subtraktion, aber es war die Grundlage für die deutsche Leibniz, fast 100 Jahre später, im 18. Jahrhundert, einen ähnlichen Apparat zu entwickeln, jedoch mit Multiplikationen und Divisionen..

Diese drei Kreationen waren die ersten computergestützten Prozesse, die aufgezeichnet wurden. Es dauerte fast 200 weitere Jahre, bis diese Disziplin an Relevanz gewann und zu einer Wissenschaft wurde.

In den frühen Jahrzehnten des 20. Jahrhunderts war die Entwicklung der Elektronik der letzte Anstoß für moderne Computer. Von dort aus beginnt dieser Wissenschaftszweig, technische Probleme zu lösen, die sich aus neuen Technologien ergeben.

Zu dieser Zeit gab es einen Wechsel von auf Zahnrädern und Stäben basierenden Systemen zu neuen Prozessen elektrischer Impulse, klassifiziert durch eine 1, wenn der Strom fließt, und durch eine 0, wenn dies nicht der Fall ist, was diese Disziplin revolutionierte.

Der letzte Schritt wurde während des Zweiten Weltkriegs mit der Herstellung des ersten Computers, des Mark I, unternommen, der ein neues Entwicklungsfeld eröffnete, das sich immer noch erweitert..

Grundbegriffe der Informatik

Informatik, verstanden als automatische Verarbeitung von Informationen durch elektronische Geräte und Computersysteme, muss über einige Fähigkeiten verfügen, um sich entwickeln zu können.

Drei zentrale Operationen sind wesentlich: Eingabe, die sich auf die Erfassung von Informationen bezieht; die Verarbeitung der gleichen Informationen und der Ausgabe, die die Möglichkeit der Übertragung von Ergebnissen ist.

Der Satz dieser Fähigkeiten von elektronischen Geräten und Computersystemen ist als Algorithmus bekannt, bei dem es sich um den geordneten Satz systematischer Operationen handelt, mit denen eine Berechnung durchgeführt und eine Lösung gefunden werden kann.

Durch diese Prozesse entwickelte das Computing verschiedene Arten von Geräten, die die Aufgaben der Menschheit bei allen Arten von Aktivitäten zu erleichtern begannen.

Obwohl sein Anwendungsbereich keine strengen Grenzen hat, wird er hauptsächlich in industriellen Prozessen, Unternehmensführung, Informationsspeicherung, Prozesskontrolle, Kommunikation, Transport, Medizin und Bildung eingesetzt..

Generationen

Innerhalb von Computing und Computing kann man von fünf Generationen von Prozessoren sprechen, die die moderne Geschichte von ihrer Entstehung im Jahr 1940 bis zur Gegenwart geprägt haben.

Erste Generation

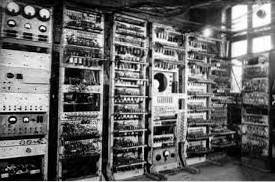

Die erste Generation hatte ihre Entwicklung zwischen 1940 und 1952, als Computer mit Ventilen gebaut und betrieben wurden. Seine Entwicklung und Nützlichkeit lag im Wesentlichen auf einem wissenschaftlich-militärischen Gebiet..

Diese Geräte hatten mechanische Schaltkreise, deren Werte geändert wurden, um entsprechend den erforderlichen Zwecken programmiert werden zu können..

Zweite Generation

Die zweite Generation wurde zwischen 1952 und 1964 mit dem Auftreten von Transistoren entwickelt, die die alten Röhren ersetzten. So entstanden die kommerziellen Geräte, die zuvor programmiert waren.

Eine weitere zentrale Tatsache dieser Phase ist das Erscheinen der ersten Codes und Programmiersprachen Cobol und Fortran. Jahre später folgten neue.

Dritte Generation

Die dritte Generation hatte eine etwas kürzere Entwicklungszeit als ihre Vorgänger. Sie dauerte zwischen 1964 und 1971, als integrierte Schaltkreise auftauchten.

Die geringeren Kosten bei der Herstellung der Geräte, die Erhöhung der Speicherkapazität und die Verringerung der physischen Größe kennzeichneten diese Phase.

Dank der Entwicklung von Programmiersprachen, die an Spezifität und Fähigkeiten gewonnen haben, blühten außerdem die ersten Hilfsprogramme auf..

Vierte Generation

Die vierte Generation wurde ab 1971 hergestellt und dauerte ein Jahrzehnt bis 1981, wobei elektronische Komponenten die Hauptakteure der Evolution waren.

Auf diese Weise tauchten die ersten Mikroprozessoren in der Computerwelt auf, die alle Grundelemente der alten Computer in einer einzigen integrierten Schaltung umfassten..

Fünfte Generation

Schließlich begann die fünfte Generation 1981 und erstreckt sich bis in die Gegenwart, in der Technologie in jeden Aspekt moderner Gesellschaften eindringt..

Die Hauptentwicklung dieser Evolutionsphase des Rechnens waren Personal Computer (PCs), die später zu einer großen Gruppe zugehöriger Technologien führten, die heute die Welt regieren..

Verweise

- InformierenDachboden, Information und Kommunikation, Soziale Dokumentation: Journal of Social Studies and Applied Technology ', 1999.

- Informationsverarbeitung (automatisch), Diego Dikygs, digitale Website Notions of Computing, 2011.

- Computergeschichten, Patricio villalva.

- Zeitschrift Horizonte Inform MagazinezuBildungsethik, Buenos Aires, 1999.

Bisher hat noch niemand einen Kommentar zu diesem Artikel abgegeben.