Skinner und in operanter Konditionierung

1938 wiederholte BF Skinner in dem Versuch, die instrumentelle Reaktion so weit wie möglich zu messen und zu objektivieren und sie gleichzeitig von den von Thorndike verwendeten mentalistischen Begriffen (wie befriedigenden oder ärgerlichen Konsequenzen) zu befreien, das Wirkungsgesetz und formulierte es als das Gesetz der Verstärkung neu.

Nach dem Gesetz der Verstärkung lernen Organismen neue Verhaltensweisen, denen eine Verstärkung folgt. und wir wissen, dass sie verstärkt wurden, weil dies die Wahrscheinlichkeit erhöht, dass diese Verhaltensweisen in Zukunft wieder auftreten werden.

Inhalt

- Skinner's Box

- Der Prozess der operanten Konditionierung

- Entbehrung

- Anpassung an den Käfig

- Schulung für Lebensmittelspender

- Modellierung durch Differenzialverstärkung oder sukzessive Approximationen

- Literaturverzeichnis

Skinner's Box

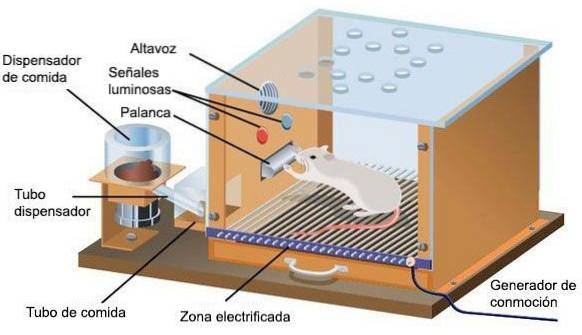

Skinner verwirklichte die Demonstration des Gesetzes der Verstärkung, indem er den operanten Konditionierungsprozess mit dem von ihm entworfenen Käfig etablierte, der Skinners Kiste genannt wurde..

Der Begriff operante Konditionierung bezieht sich auf den Prozess, durch den die Häufigkeit der Darstellung eines Verhaltens durch seine Konsequenzen verändert wird. Die Wahrscheinlichkeit des Auftretens eines operanten Verhaltens wird daher hauptsächlich durch die Ereignisse bestimmt, die nach der Durchführung dieses Verhaltens in der Vergangenheit aufgetreten sind. Skinner führte den Begriff Operantenverhalten ein, um alle Antworten zu definieren, die die gleichen Auswirkungen auf die Umgebung haben. In diesem Sinne kann das operative Verhalten beim Drücken des Hebels von einer Ratte ausgeführt werden, die unterschiedliche Reaktionen ausführt, wie zum Beispiel das Drücken mit einer Pfote, mit der Nase oder mit dem Schwanz. Alle diese Antworten bilden denselben Operanden.

Dieses Gerät ermöglichte es einem Tier wie einer Ratte (er verwendete auch Tauben als Versuchspersonen), ein willkürliches Verhalten wie das Drücken eines Hebels zu lernen, vorausgesetzt, auf die Leistung dieses Verhaltens folgte die sofortige Präsentation von Futter, das dieses operante Verhalten verstärken würde . Die von Skinner entworfene Box basiert auf den folgenden Elementen:

- Ein Hebel im Käfig, auf den das Tier drücken muss, um Futter zu erhalten, und der automatisch mit dem Mechanismus verbunden ist, der den kleinen Futterball ausgibt, der in den Futterautomaten neben dem Hebel fällt..

- Ein kumulativer Aufzeichnungsmechanismus, der grafisch anzeigt, wann und wie oft das Tier während der Sitzung reagiert.

Der Prozess der operanten Konditionierung

Ein typisches operantes Konditionierungsverfahren besteht aus den folgenden Schritten:

Entbehrung

Es geht darum, der Ratte, die konditioniert wird, das Fressen zu entziehen, bis sie 80% ihres normalen Gewichts erreicht hat, dh bis sie eine Gewichtsreduktion von 20% erreicht.

Anpassung an den Käfig

Während der Anpassungssitzungen wird das Tier in den Käfig gebracht, um die typischen Erkundungsreaktionen der Ratte zu gewöhnen und auch das anfängliche Betriebsniveau des Tieres zu beobachten. Das heißt, wie oft drücken Sie den Hebel, bevor Sie mit der Konditionierung dieser Reaktion beginnen. Diese Betriebsbasislinie dient als Referenz, um den nachfolgenden Anstieg der Rücklaufquote zu überprüfen, der durch das Vorhandensein der Verstärkung verursacht wird..

Schulung für Lebensmittelspender

Diese Phase hat ein doppeltes Ziel: Einerseits, dass das Tier weiß, wo das Futter erscheinen wird, und andererseits, dass es durch klassische Konditionierung lernt, das Geräusch des Futterausgabemechanismus (Geräusch, das wird) zu assoziieren ein konditionierter Reiz oder ein Signal für das Vorhandensein von Nahrung) mit der Verfügbarkeit von Nahrung in der Krippe.

Modellierung durch Differenzialverstärkung oder sukzessive Approximationen

In dieser Phase lernt das Tier das Bedienverhalten beim Drücken des Hebels. Um dies zu erreichen, erhält das Tier jedes Mal, wenn es eine Bewegung macht, die Teil des endgültigen Verhaltens ist oder es dem endgültigen Verhalten näher bringt, Nahrung. So wird beispielsweise die Verstärkung nur dann präsentiert, wenn die folgenden Verhaltensweisen auftreten: Zunächst wird verstärkt, dass die Ratte auf den Hebel ausgerichtet ist; später, wenn es näher kommt; später, wenn Sie die Beine über den Hebel heben; und schließlich, wenn Sie den richtigen Druck auf den Hebel ausüben.

Die Modellierungstechnik für die Differenzialverstärkung wird verwendet, um die Wahrscheinlichkeit des Auftretens eines Verhaltens zu erhöhen, das im normalen Repertoire des Organismus praktisch nicht vorhanden ist, das jedoch keine physikalische Einschränkung für die Ausführung darstellt. Diese Technik erfordert die Planung und Sequenzierung der verschiedenen Schritte, die ausgeführt werden müssen, um das endgültige Zielverhalten zu erreichen, in aufsteigender Reihenfolge der Schwierigkeit, um die Verstärkung erst nach jedem dieser vorherigen Verhaltensweisen zu verabreichen. Somit kann es sowohl verwendet werden, um einer Ratte das Drücken eines Hebels beizubringen, um einer Taube das Klavierspielen beizubringen oder um den Blindenhund eines Blinden zu trainieren. Das Modellieren ist jedoch besonders nützlich, um Kindern (die natürlich nur schwer auftreten können) oder Menschen mit geistiger Behinderung komplexe Verhaltensweisen beizubringen. Diese Technik basiert auch auf verschiedenen Verhaltenstherapien, wie beispielsweise der sogenannten systematischen Desensibilisierung, mit der die Person näher an das Objekt oder die Situation herangeführt wird, die anfänglich Abneigung hervorruft.

Um die Stärke der operanten Konditionierung zu beurteilen, maß Skinner kontinuierlich die Häufigkeit oder Geschwindigkeit der Reaktion, mit der die Ratte den Hebel drückte. Diese von Skinner entwickelte experimentelle Methode nennt Free Operant, da Tiere die instrumentelle Reaktion beliebig oft wiederholen können, ohne dass der Forscher daran teilnehmen muss. Die Methode der freien Operanden ist der von Thorndike ursprünglich verwendeten Methode "Versuch für Versuch" entgegengesetzt, da bei dieser Methode derselbe Experimentator den Beginn jedes Versuchs markiert. Daher ist eine direkte Manipulation des Tieres erforderlich, um es nach Durchführung des instrumentellen Verhaltens wieder in die Versuchskammer zu bringen.

Das von Skinner initiierte und entwickelte operative Konditionierungsverfahren ermöglichte es ihm, das Verhalten vorherzusagen und zu kontrollieren. Dieses Wissen war in verschiedenen Bereichen der Psychologie von wesentlicher Bedeutung: Sie hatten daher Auswirkungen, hauptsächlich auf den klinischen Bereich oder auf Verhaltenstherapien, auf den Bereich der Lehre und auf soziale Aspekte.

Literaturverzeichnis

A.B. Sulzer i M.G. Roy (1983). Verhaltensanalyseverfahren für Kinder und Jugendliche. Mexiko: Dreschen.

D.L. Whaley i R.W. Malott (1983). Verhaltenspsychologie. Barcelona: Fontanella.

Bisher hat noch niemand einen Kommentar zu diesem Artikel abgegeben.